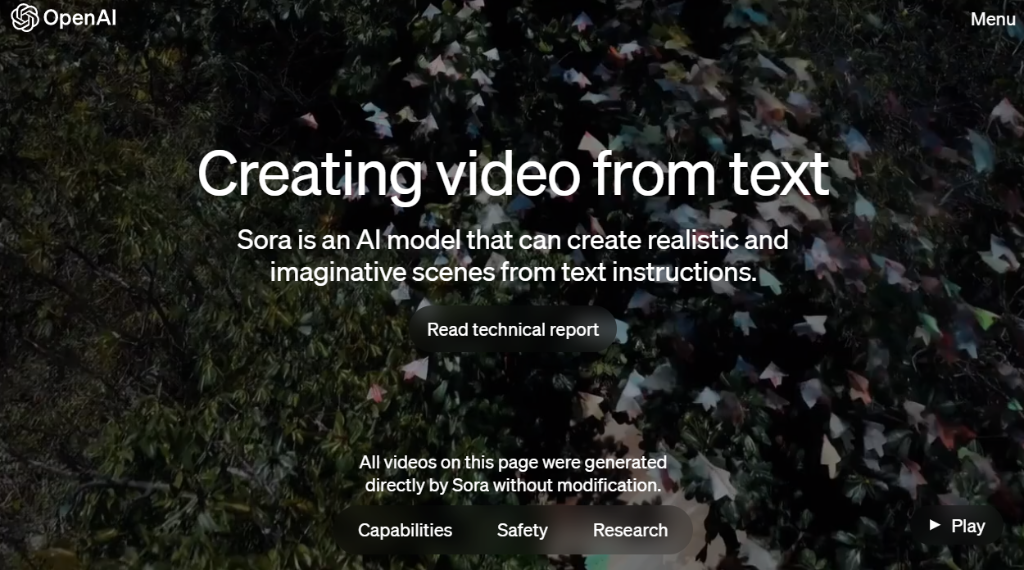

OpenAI官网截图

输入寥寥数语便能生成效果炸裂的60秒视频!美国开放人工智能研究中心(OpenAI)推出的视频生成模型Sora近日震惊全球。

OpenAI推出ChatGPT才过去一年多,就再度扔出一枚重磅炸弹。“文生视频”AI模型Sora的惊艳之处在哪儿?对行业有何影响?存在哪些隐患?新华社记者为你解局——

Sora有何本领

Sora生成的多条短视频“大片”在全网刷屏,场景逼真丝滑、细节丰富。

这是OpenAI首次进军AI视频生成领域。据公司介绍,Sora使用Transformer架构,可根据文本指令创建现实且富有想象力的场景,生成多种风格、不同画幅、最长为一分钟的高清视频。

换句话说,给Sora一些提示语,它就能生产出一条高质量短视频。一起感受一下Sora的创作实力。

OpenAI官网发布的Sora生成视频图像显示,一辆SUV行驶在盘山公路上。

Sora还能够根据静态图像生成视频,扩展现有视频或填充缺失的帧。

OpenAI说,Sora能深刻地理解语言,不仅理解用户文本提示,还理解所述事物在物理世界中的存在方式。“我们正在教授人工智能理解和模拟运动中的物理世界,目标是训练模型帮助人们解决需要与现实世界交互的问题。”

不过,OpenAI官网晒出的视频作品是Sora创造的平均水准还是最高水准呢?

OpenAI承认,目前Sora生成视频中可能包含不合逻辑的图像,混淆左右等空间细节,难以准确模拟复杂场景的物理原理和因果关系实例等。例如,一个人可能咬了一口饼干,但饼干上没有咬痕。不过,随着算力增强、模型改进,人们可能会在短期内获得更加完善、先进的视频生成功能。

可能砸掉谁的饭碗OpenAI此次推出Sora更像是预览版,公众尚难以深入全面了解该模型的优缺点。OpenAI表示,目前仅主要向一些设计师和电影制作人等特定人群提供Sora访问权限,以获取有关改进该模型的反馈。公司不仅未公布训练Sora模型的数据等基础细节,也没确定何时面向公众发布。

Sora生成视频截图

一些分析人士认为,Sora再次凸显人工智能技术进步对现实生活和传统行业的深远影响。人工智能在视频生成领域的巨大发展前景为塑造影视产业新业态打开大门的同时,恐将颠覆现存影视产业。

Sora推出第二天,主营图像处理、视频制作软件的奥多比公司股价应声下跌超过7%。

好莱坞去年遭遇63年来首次编剧和演员全行业罢工,因为该行业的部分工作机会可能被人工智能取代。Sora横空出世让这一威胁变得更迫近和真切。

让伪造更逼真难辨

OpenAI在Sora技术报告的标题中写道,视频生成模型是“世界模拟器”。

如果世界可以被模拟,那么真与假的边界何在?不少业内人士担心,Sora将为“深度伪造”(Deepfake)技术推波助澜。加利福尼亚大学伯克利分校信息学院副院长法里德表示:“当新闻、图像、音频、视频——任何事情都可以伪造时,那么在那个世界里,就没有什么是真实的。”

图为2023年11月2日,在英国布莱奇利园,一名参会者经过首届人工智能安全峰会的宣传展板。新华社

记者李颖摄

针对造假顾虑,OpenAI称在真正面向公众推出产品时,将确保生成视频包含来源元数据,并推出检测视频真伪的工具。OpenAI还承诺,在产品中使用Sora前将采取安全措施,包括由“错误信息、仇恨内容和偏见等领域的专家”对模型进行对抗性测试以评估危害或风险;核查并拒绝包含极端暴力、性内容、仇恨图像、他人IP等文本输入提示等。

不过,OpenAI承认,即便进行了广泛的研究和测试,“我们无法预测人们使用我们技术的所有有益方式和滥用我们技术的所有方式”。

AI狂飙 能管得住吗科技领域颠覆式创新不断涌现,如何实现拥抱技术进步和确保社会安全的平衡,越来越受到各界关注。

OpenAI表示,将与世界各地的政策制定者、教育工作者和艺术家合作,了解他们的担忧,确定Sora的积极使用案例,并认为从现实世界的使用中学习是创建和发布越来越安全的人工智能系统的关键组成部分。

2023年7月7日,在瑞士日内瓦“人工智能造福人类全球峰会”上,一名参会者与仿真机器人索菲亚互动。新

华社记者连漪摄

业内人士指出,在当下治理框架、管控措施都未跟上的情况下,仅靠企业恐无法提供社会所需的人工智能安全性和信任度。

原文转自新华网:

https://www.xinhuanet.com/

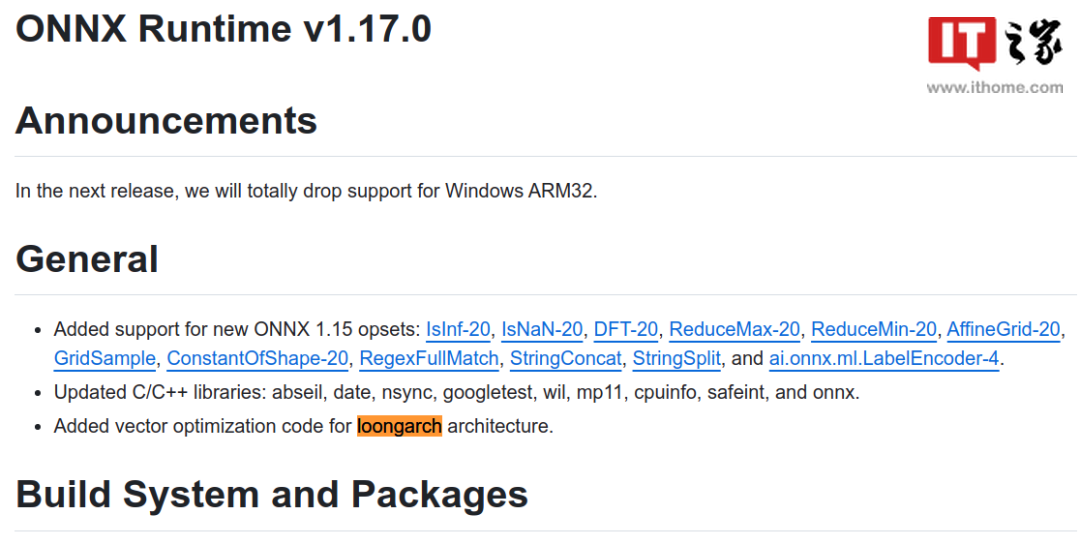

IT之家注:ONNX Runtime(ORT)是近年来兴起的 AI 推理框架软件,被大量 AI 应用作为基础 AI 推理引擎。ORT 可支持 PyTorch、Tensorflow、TFLite 等多种格式的模型输入,以及 CPU、GPU、IoT、NPU、FPGA 等多样化算力后端。

IT之家注:ONNX Runtime(ORT)是近年来兴起的 AI 推理框架软件,被大量 AI 应用作为基础 AI 推理引擎。ORT 可支持 PyTorch、Tensorflow、TFLite 等多种格式的模型输入,以及 CPU、GPU、IoT、NPU、FPGA 等多样化算力后端。  龙芯中科表示,在 ONNX Runtime 社区 1.17.0 版本的研制过程中,龙芯中科技术团队与社区保持紧密合作,期间向 ONNX Runtime 社区代码仓库提交了 7697 行代码,对矩阵乘法、卷积、转置等核心算子进行深度向量优化。 在社区支持下,龙架构优化代码通过了检视、测试验证等质量保证流程,ONNX Runtime 社区自 1.17.0 版本起正式实现对龙架构的原生支持。 原文转自IT之家:

龙芯中科表示,在 ONNX Runtime 社区 1.17.0 版本的研制过程中,龙芯中科技术团队与社区保持紧密合作,期间向 ONNX Runtime 社区代码仓库提交了 7697 行代码,对矩阵乘法、卷积、转置等核心算子进行深度向量优化。 在社区支持下,龙架构优化代码通过了检视、测试验证等质量保证流程,ONNX Runtime 社区自 1.17.0 版本起正式实现对龙架构的原生支持。 原文转自IT之家:

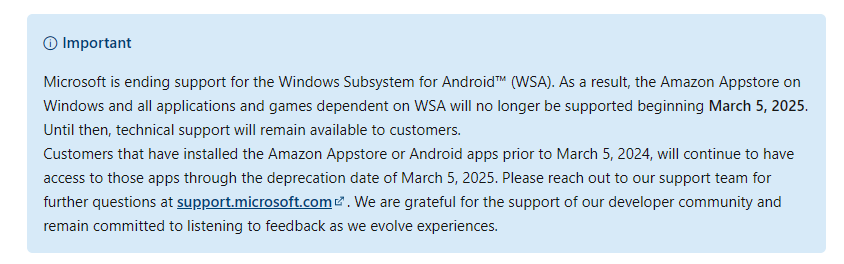

WSA 官方则更清楚的表示,微软将终止对 Windows Subsystem for Android™️ (WSA) 的支持。从 2025 年 3 月 5 日开始,将不再支持 Windows 上的亚马逊应用商店以及所有依赖于 WSA 的应用程序和游戏。在此之前,仍将为客户提供技术支持。在 2024 年 3 月 5 日之前安装了亚马逊应用商店或安卓应用的客户,在 2025 年 3 月 5 日的弃用日期之前,将继续有权访问这些应用。

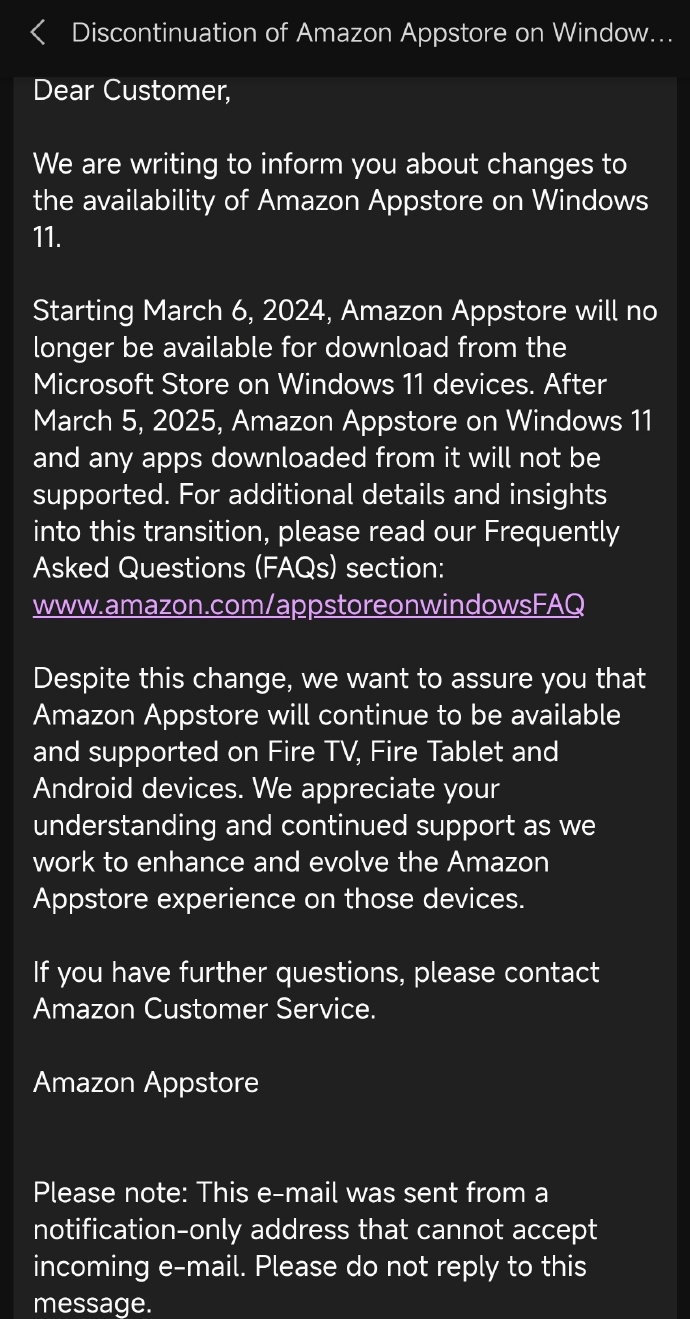

WSA 官方则更清楚的表示,微软将终止对 Windows Subsystem for Android™️ (WSA) 的支持。从 2025 年 3 月 5 日开始,将不再支持 Windows 上的亚马逊应用商店以及所有依赖于 WSA 的应用程序和游戏。在此之前,仍将为客户提供技术支持。在 2024 年 3 月 5 日之前安装了亚马逊应用商店或安卓应用的客户,在 2025 年 3 月 5 日的弃用日期之前,将继续有权访问这些应用。  与此同时,亚马逊也发布通知。从 2024 年 3 月 6 日开始,亚马逊应用商店将不再提供

与此同时,亚马逊也发布通知。从 2024 年 3 月 6 日开始,亚马逊应用商店将不再提供  据IT之家此前报道,微软于 2021 年 9 月宣布,允许 Epic Games、亚马逊等公司将其应用商店整合到 Microsoft Store,以便为第三方开发者提供更多选择。 微软称其致力于成为一个“面向开放平台的开放商店”,当应用管理自己的应用内支付系统时,Windows 系统的 Microsoft Store 不再要求应用开发者与微软分享收益。

原文转自IT之家:

据IT之家此前报道,微软于 2021 年 9 月宣布,允许 Epic Games、亚马逊等公司将其应用商店整合到 Microsoft Store,以便为第三方开发者提供更多选择。 微软称其致力于成为一个“面向开放平台的开放商店”,当应用管理自己的应用内支付系统时,Windows 系统的 Microsoft Store 不再要求应用开发者与微软分享收益。

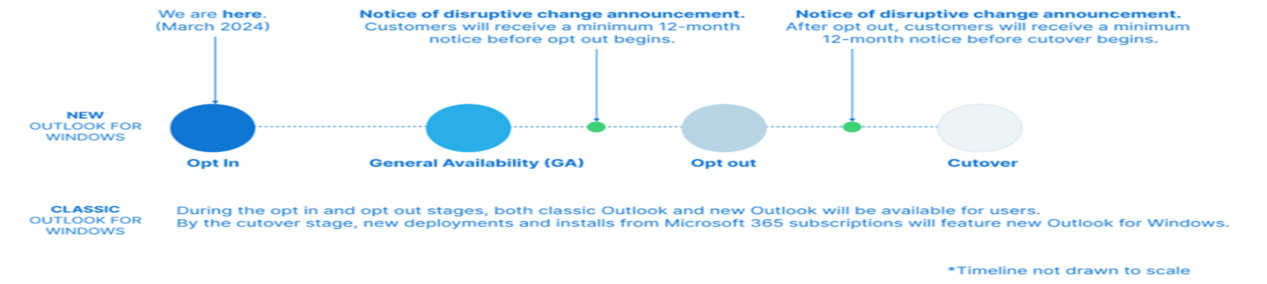

原文转自IT之家: 微软将使用与 Mac 版 Outlook 的新版本相同的分阶段方法向商业客户持续部署 WebView 2 版 Outlook,在此过程中微软承诺将继续遵守已经发布的 Outlook for Windows 现有版本支持时间表,保证相关应用在 2029 年以前都能得到主线支持。

微软将使用与 Mac 版 Outlook 的新版本相同的分阶段方法向商业客户持续部署 WebView 2 版 Outlook,在此过程中微软承诺将继续遵守已经发布的 Outlook for Windows 现有版本支持时间表,保证相关应用在 2029 年以前都能得到主线支持。

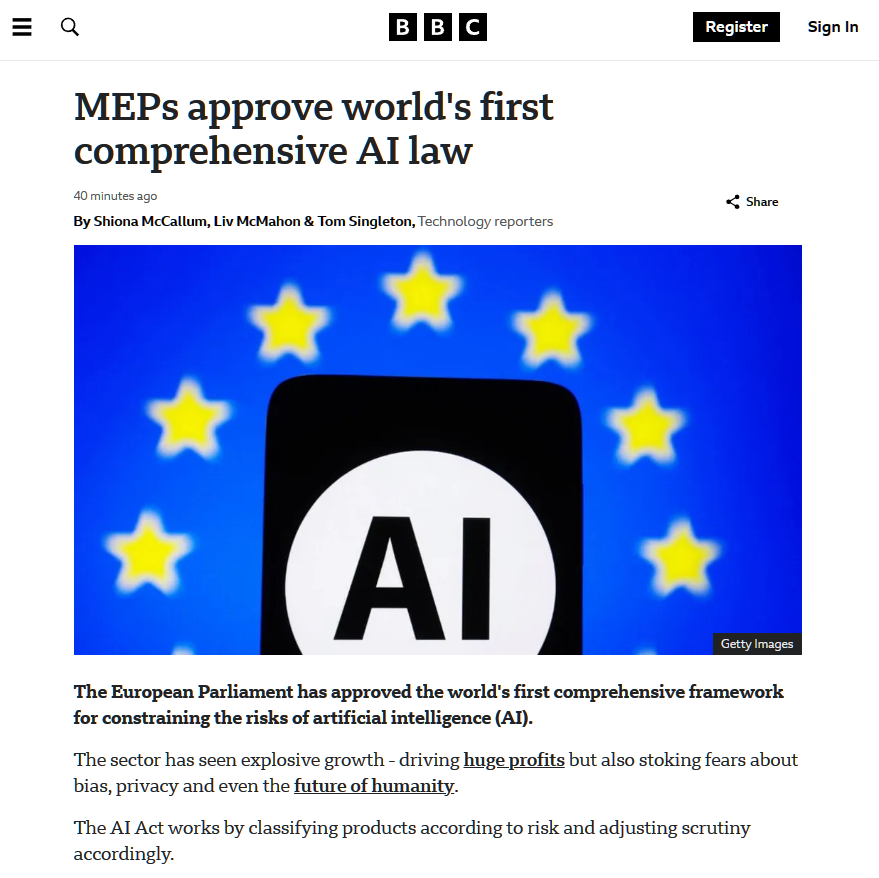

综合界面新闻、BBC 报道,该法案将禁止一部分“威胁公民权利”的人工智能应用,包括基于敏感特征的生物识别分类系统,以及从互联网或闭路电视录像中无目标地抓取面部图像,以创建面部识别数据库。此外,操纵人类行为或利用人类弱点的人工智能也将被禁止。 该法案将根据风险对产品进行分类并相应调整审查,其主要思想是根据人工智能对社会造成危害的能力对其进行监管:风险越高,规则就越严格。

综合界面新闻、BBC 报道,该法案将禁止一部分“威胁公民权利”的人工智能应用,包括基于敏感特征的生物识别分类系统,以及从互联网或闭路电视录像中无目标地抓取面部图像,以创建面部识别数据库。此外,操纵人类行为或利用人类弱点的人工智能也将被禁止。 该法案将根据风险对产品进行分类并相应调整审查,其主要思想是根据人工智能对社会造成危害的能力对其进行监管:风险越高,规则就越严格。

2 月 15 日消息,微软在本月的补丁星期二活动中,发布了适用于 Windows 11 的 KB5034765,以及适用于 Windows 10 的 KB5034763 累积更新,修复了 73 个安全漏洞和 2 个零日漏洞。 IT之家基于微软 2 月累积更新日志,附上修复的漏洞数量如下:

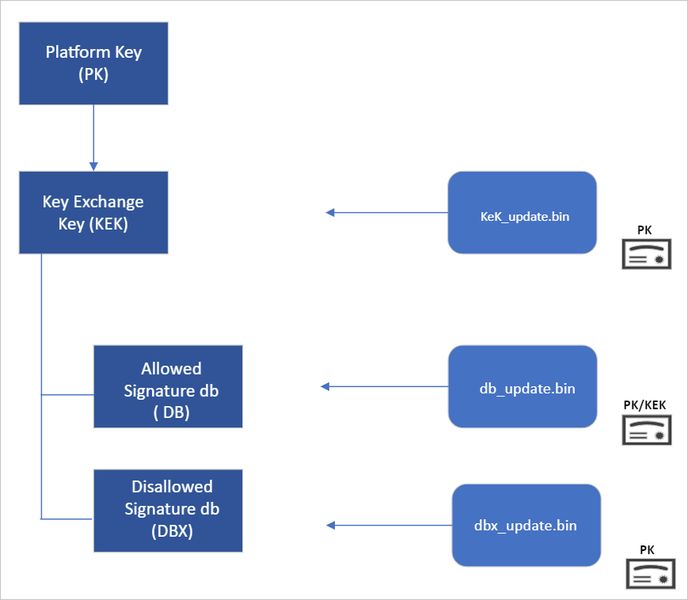

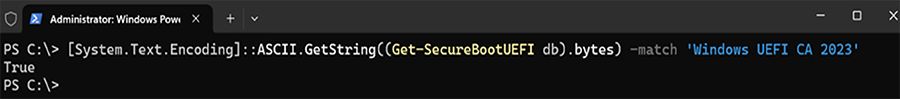

2 月 15 日消息,微软在本月的补丁星期二活动中,发布了适用于 Windows 11 的 KB5034765,以及适用于 Windows 10 的 KB5034763 累积更新,修复了 73 个安全漏洞和 2 个零日漏洞。 IT之家基于微软 2 月累积更新日志,附上修复的漏洞数量如下: 如果这些 bootkits 植入成功,很可能会逃过反恶意软件的侦测。微软要求 OEM 厂商预装以下三个管理证书:

如果这些 bootkits 植入成功,很可能会逃过反恶意软件的侦测。微软要求 OEM 厂商预装以下三个管理证书:

NPU(神经网络处理单元)是一种专门的硬件,旨在加速人工智能和机器学习工作负载。IT之家注意到,虽然 AMD 是第一家发布 NPU 硬件的公司,并且将其应用于笔记本电脑和台式机,但由于目前微软的 DirectML API 不支持 AMD 的芯片,导致 Windows 系统内的 AI 加速功能暂时无法使用。 相比之下,英特尔处于稍微有利的位置,因为微软最近宣布了对该公司的 DirectML NPU 支持现在处于预览阶段。不过,AMD 的形势正在好转。通过启用 MCDM,任务管理器将能够显示 NPU 的使用情况,这对于监控 AMD 笔记本电脑的功耗和性能至关重要。 AMD 表示,监控 NPU 使用情况对于笔记本电脑用户来说非常有用,可以帮助他们更有效地管理电量。他们写道:“能够实时跟踪资源分配情况以及哪些系统组件处于负载状态,对于监控应用程序行为非常有用。这种跟踪在笔记本电脑上尤其重要,因为最终用户可以选择通过控制某些工作负载运行的位置或调整全局电源设置来最大限度地延长电池续航。” AMD 认为,这与微软在

NPU(神经网络处理单元)是一种专门的硬件,旨在加速人工智能和机器学习工作负载。IT之家注意到,虽然 AMD 是第一家发布 NPU 硬件的公司,并且将其应用于笔记本电脑和台式机,但由于目前微软的 DirectML API 不支持 AMD 的芯片,导致 Windows 系统内的 AI 加速功能暂时无法使用。 相比之下,英特尔处于稍微有利的位置,因为微软最近宣布了对该公司的 DirectML NPU 支持现在处于预览阶段。不过,AMD 的形势正在好转。通过启用 MCDM,任务管理器将能够显示 NPU 的使用情况,这对于监控 AMD 笔记本电脑的功耗和性能至关重要。 AMD 表示,监控 NPU 使用情况对于笔记本电脑用户来说非常有用,可以帮助他们更有效地管理电量。他们写道:“能够实时跟踪资源分配情况以及哪些系统组件处于负载状态,对于监控应用程序行为非常有用。这种跟踪在笔记本电脑上尤其重要,因为最终用户可以选择通过控制某些工作负载运行的位置或调整全局电源设置来最大限度地延长电池续航。” AMD 认为,这与微软在